AI不是你在癌症危機中所需的那位醫生

一路走來經歷了鼻胃管到最後芬太尼成癮,癌症治療護理有很多面向無法單靠AI完成,需要真人留心。

「我罹癌了。」

每年全球有超過兩千萬人需要啟齒這幾個字。

我是其中之一。

我在二零二四年的聖誕節前兩天第一次將這四個字說出口,那時,我的癌症進入第三期,它已經轉移。

罹癌這件事難以平淡地接收也無法輕鬆地分享,被確診後的生活永遠無法與往日相提並論。

這一陣子的抗癌經驗讓我深深體會到:縱然全球百分之二十的人口可能罹癌1,每一位癌友的心路歷程都是獨一無二的、而且無比孤寂。

癌症是一種特殊的疾病,這個疾病的字眼讓我聯想到蜘蛛,當我們帶著一點距離看到蜘蛛的時候,或許感到好奇、或許感到不舒服,但是當蜘蛛垂降到我們身上時,只剩下無限的驚慌!癌症病情的所有細小改變,都需要被持續關注,但是它有別於其他慢性病如糖尿病、狼瘡或心臟病,無法只是維持與共存。癌症必須被消滅。

我罹癌的時間點,改上了AI熱潮,絕大多數病人不使用Google反而選擇諮詢ChatGPT、Claude或Perplexity;商討內容小至感冒護理大至癌症療程等各種疑難雜症,我也不例外。

AI乍看完美,直到它不再美好的那一天。

研究顯示,臨床上使用AI,在最好的演算法的前提下,會出現百分之十五的失誤,但最差情況接近百分之四十。值得擔憂的是即便出錯率極低,但非零出錯率會造成偏差:醫療人員相信AI更勝自己的專業知識。

另一份研究點出了Limitations of using large-language models (LLMs) in healthcare。作者提出了十四個議題:包含無法從經驗中學習,不會擷取話中含意也缺少情商。他寫道:「ChatGTP無法體會到使用者的情緒也無法同理他們的感受。」「不可能了解病患尷尬的一撇。」

人類的專職

最後提出的這個議題—情商(EQ)—在AI逐漸在醫藥界佔有一席之地的過程中被遺忘了。但這是身為醫生、護理師和醫療勤務人員最重要的素養之一。醫護業比其他職業更需要人性,醫療人員和病人緊密連結,一起歷經生病、內心恐懼、甚至死亡。

我的全科醫生是第一個向我宣布癌症評估的人。她告知我的時候,神情肅穆,話語中一邊提供醫療建議一邊不斷夾雜抱歉。她在檢查其他問題時偶然間發現了警訊,請我做進一步的掃描。任何影像辨識模型都無法辨識經驗豐富的醫生親手觸摸的感受,也無法有如同高情商臨床醫生的同理心來向患者傳達這個消息。我想,即便是長得最像人類的機器人告訴我我可能會死,我也是無法接受的。

告知家人壞消息和提早結束聖誕假期後,我開始無止盡上網搜尋:療程、存活率、副作用,高度有自信的聊天機器人一派輕鬆地分享對應策略,好似一位經驗老道的醫生在視窗的另一端和我說話。然而,對話後我感到更糟糕更孤單也更脆弱。

我的醫療團隊有一位血液腫瘤科醫生、兩位腫瘤科醫生和一位外科醫生。即便和真人醫療團隊討論後,我依然無法停止在AI世界鑽研。我這麼做的目的不是為了比較挑選醫生,團隊裡的每個專家在療程中扮演不同且重要的角色。我覺得自己像一個很認真的學生,有一次我花了一整天時間找出和我這類型癌症相關的醫療研究,把印好的四頁報告帶去和腫瘤科醫生討論,宛如完成了作業和老師交代的加分題。

我的醫生沒有因此感到厭煩或是不予理會,他曾經做過很多臨床實驗,他很開心我主動投入心力研究病情,我很老實和他說我熱愛研讀PubMed裡面的文獻資料,我的醫生對我的耐心如小學老師,他很有禮貌的轉移我對四頁報告的注意力,仔細地闡述我的病情。他進一步花時間寫下數個文獻標題,建議我多花點時間研讀和我的病況更相關的研究。他不視AI為敵人,如同Google之於上一輩的醫生,但是這種工具有其限制。

經歷幾次化療後,我深刻的體會到:知道我的癌症種類或是存活率,對我的醫療照護沒有甚麼幫助,這都只是統計數字而已;那台注入精密計算過含有鉑元素的化學混合物和安眠藥的機器,也不過是執行工程指令罷了。

真正的醫療照護,是在點滴室長達六個小時的療程,護理師堅決有耐心的第三次尋找入針的靜脈,撫慰我遇上點滴針頭的焦慮與恐慌。提供醫療照護亦非昂貴的放療儀器,是溫柔堅定的腫瘤放射科醫生,她為了把對健康組織的傷害降到最低,不斷為我安排患部立體掃描,確保連續六個星期天天精準正對腫瘤放療。

人工智慧系統或許可以協助診斷,計畫安排療程或歸納紀錄,但是它們永遠不可能有能力取代人類去安撫引導另一個人類渡過凡人脆弱和臨死的創傷。

我的腫瘤放射科醫生醫治過數百位病患。我最感謝她的時刻,是她小心翼翼把五十公分的橡膠管從鼻腔放到我的胃,讓我得以獲取需要的養分。世上只有寥寥幾件事比鼻胃管進食兩個月更不人道,機器人是不可能完成這項需要細緻手感的任務,更沒有她的細心和同理心。

我的醫療團隊也有一位有著外科醫生印象中常見的那種神氣活現的外科醫生。他時不時把「別擔心」掛在嘴邊。一開始聽到他這麼說感覺他事不關己,我罹患癌症當然會擔心。但他對患者心理狀態的理解,是LLM所無法企及的。因為:「擔憂是人類的天性,縱然毫無益處」。過了數個月兩週一次的會談,其中包含療程的不順遂,我漸漸被他「別擔心」的真言感化,我還是擔心,但相較之前少了很多。聽一位有自信的真人說話比一台有自信的聊天機器人更具有說服力,也許是他聲音的溫度或是他真誠地期許我確實沒什麼好擔心的希望。

我的病況已穩定,我有信心我會活下來。但這不是終點,未來有漫長的復健等著我,也還要繼續和副作用作戰一輩子。即便如此,我是幸運者群體的一員。

我的好運決大部分來自於我有負擔得起,且容易取得的世界級醫療資源。提供我醫生會診和療程的醫療中心在第一世界國家,由億萬富翁、富士康創辦人郭台銘先生所捐贈,他的前妻和弟弟都是被癌症帶走的。我的放射治療設備是瓦里安先進的直子放射治療系統,亦是郭先生所捐贈的,我無數癌友們也得以享受一樣的特權,這確實是一種特權。我親眼看到其中數人和我一樣換上病袍靜靜等待被輔具綁住後接受放療;然而,有些癌友卻看不到明天,幸存者的愧疚感壓得我喘不過氣。

貧窮的負擔

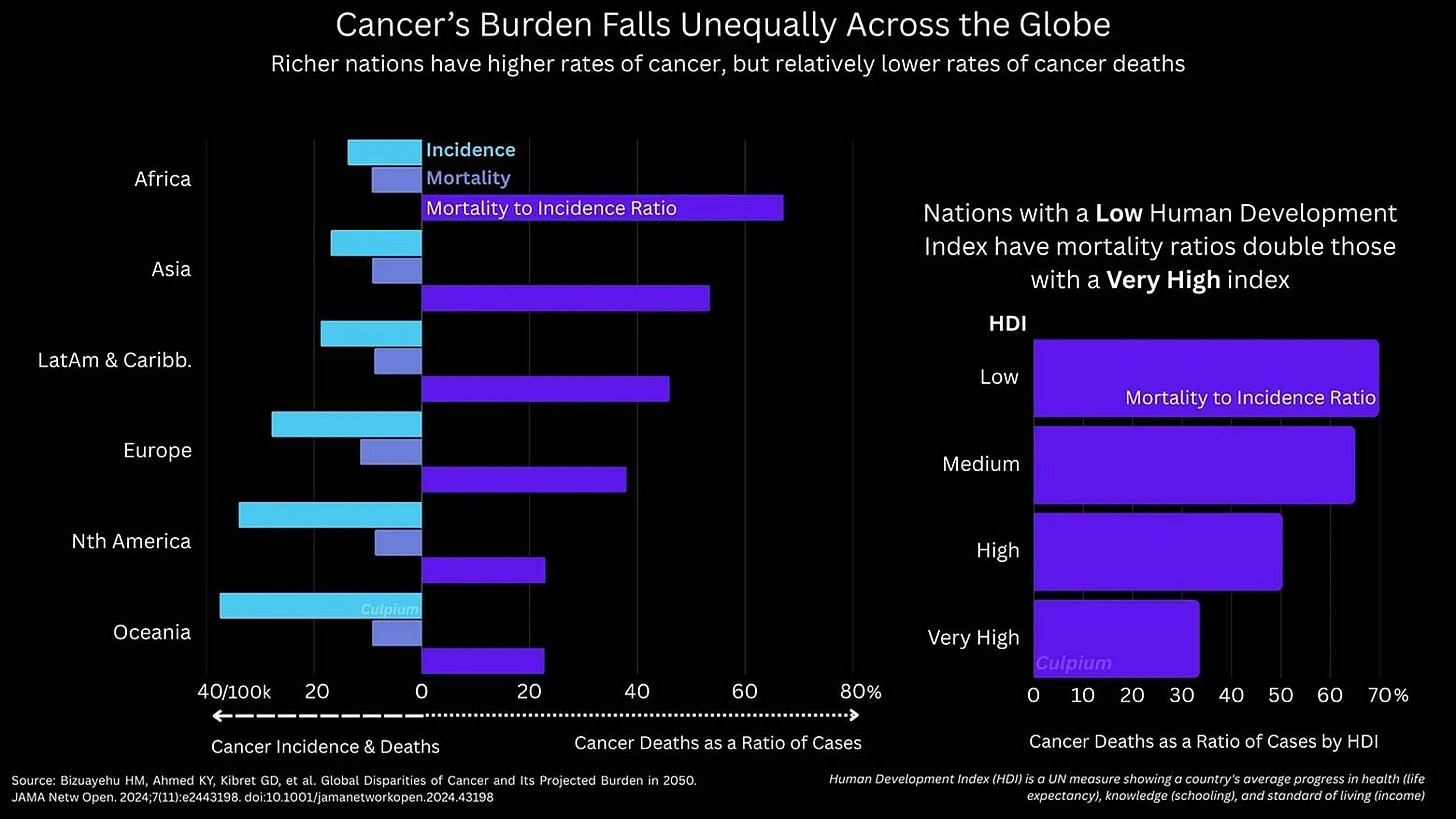

根據 The Lancet 的研究統計,二零二三年有一千八百五十萬個已知的癌症病例,其中至少一千零四十萬無法倖存,佔確診人數的百分之五十六。除了每種癌症的致死率不同,存活率亦取決於診斷時已達第幾期、年紀、健康狀況、人種以及有無其他並發症。然而統計數據顯示決定存活率最大關鍵是有無醫療資源的門路。

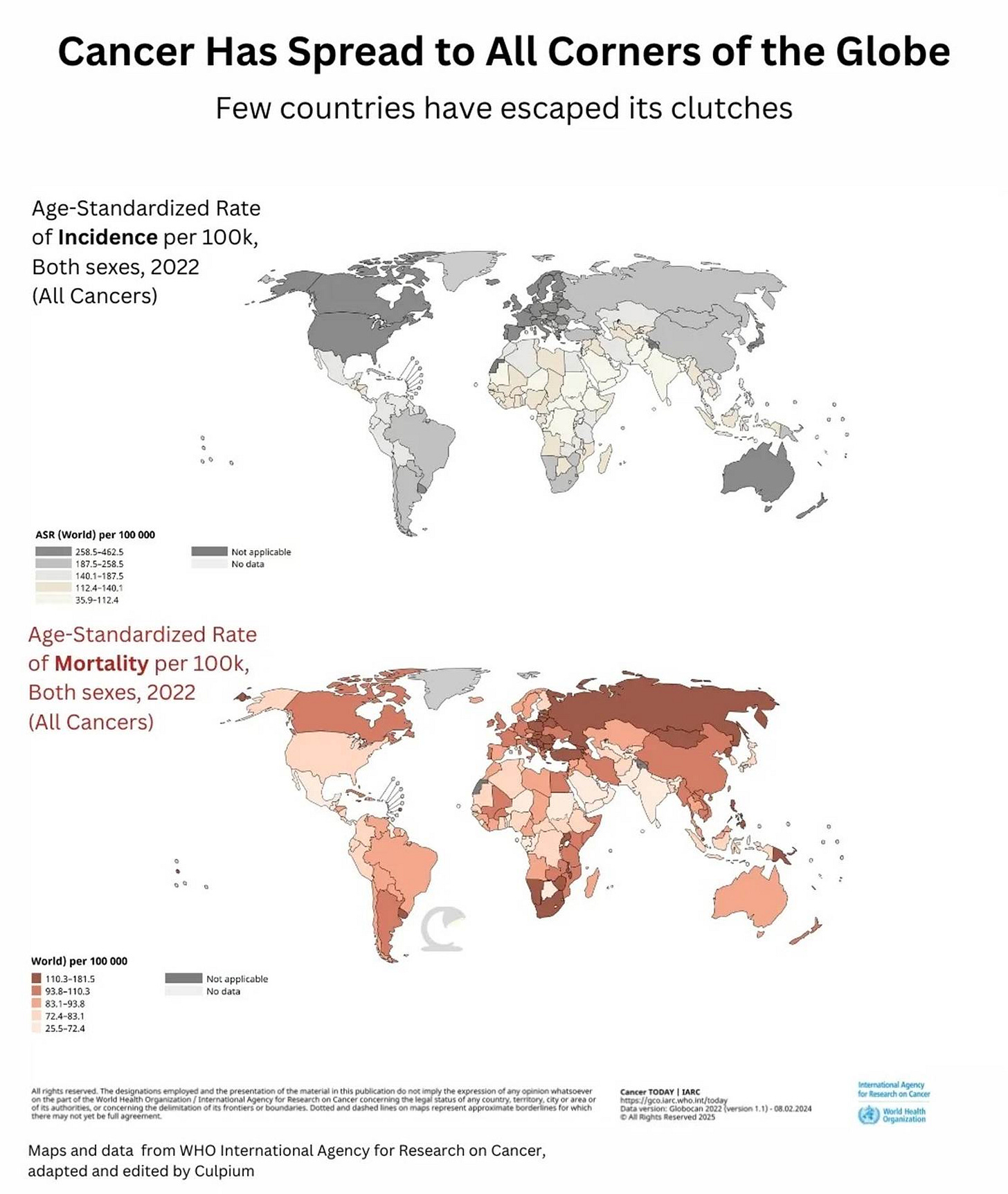

澳洲、紐西蘭、瑞典和美國的罹癌率世界最高,但從致死率角度來看,這四個國家綁上名次不高。 根據世界衛生組織統計資料顯示蒙古和辛巴威的罹癌致死率特別突出。

儘管醫療研究持續進步,本世紀下一季度罹癌率預計攀升百分之六十來到每年三千零五十萬例,死亡率預計上升至百分之七十五來到每年一千八百六十萬例,「首次確診和三分之二的死亡數會發生在中低收入國家。」Institute for Health Metrics and Evaluation 如此撰寫, The Lancet 節錄。

最後兩個事實令人震驚「一半的新案例,卻佔據三分之二的死亡數。」

對於窮人來說,癌症治療是無法承受的重擔,他們最無力負擔昂貴的化療、放療、開刀和無數的術前術後復健,因為這龐大的費用加上有限的醫療資源,貧窮的病患死亡率會不對等的更高。

全球易取得的人工智慧工具包含大語言模型,也許能夠改善這不對等關係。值得一提的是當我問身邊的醫生們,沒有一位反對運用AI輔助醫療,其中一位醫生提出他訂閱數份LLM,但也對AI的幻覺以及錯誤資訊保持謹慎之心。他回憶一起病例,病人不同的並發症讓醫生難以下診斷,ChatGPT協助集思廣益輔助醫生找到問題根源和解決方針。

然而我們不應誤解AI判診的能力。微軟六月發佈的文章標題「 The Path to Medical Superintelligence」大肆宣揚美國軟體公司「model-agnostic orchestrator」,一組電腦模擬醫生挑戰真人臨床醫生診斷病例。乍看之下電腦模擬醫生能力驚人,但進一步查驗後發現這個活動的架構有其缺陷 。挑戰題目僅限於新英格蘭醫學期刊發表過的病例,無庸置疑這些論文是這組模擬醫生的訓練來源。另一方面人類不被允許使用網路搜尋也不准和其他真人醫生協商,這兩種情況在真實世界都不太可能發生,換句話說微軟提供的是一個加強版搜尋引擎。這些診斷最初來自於人類醫生在現實生活中的臨床經驗。

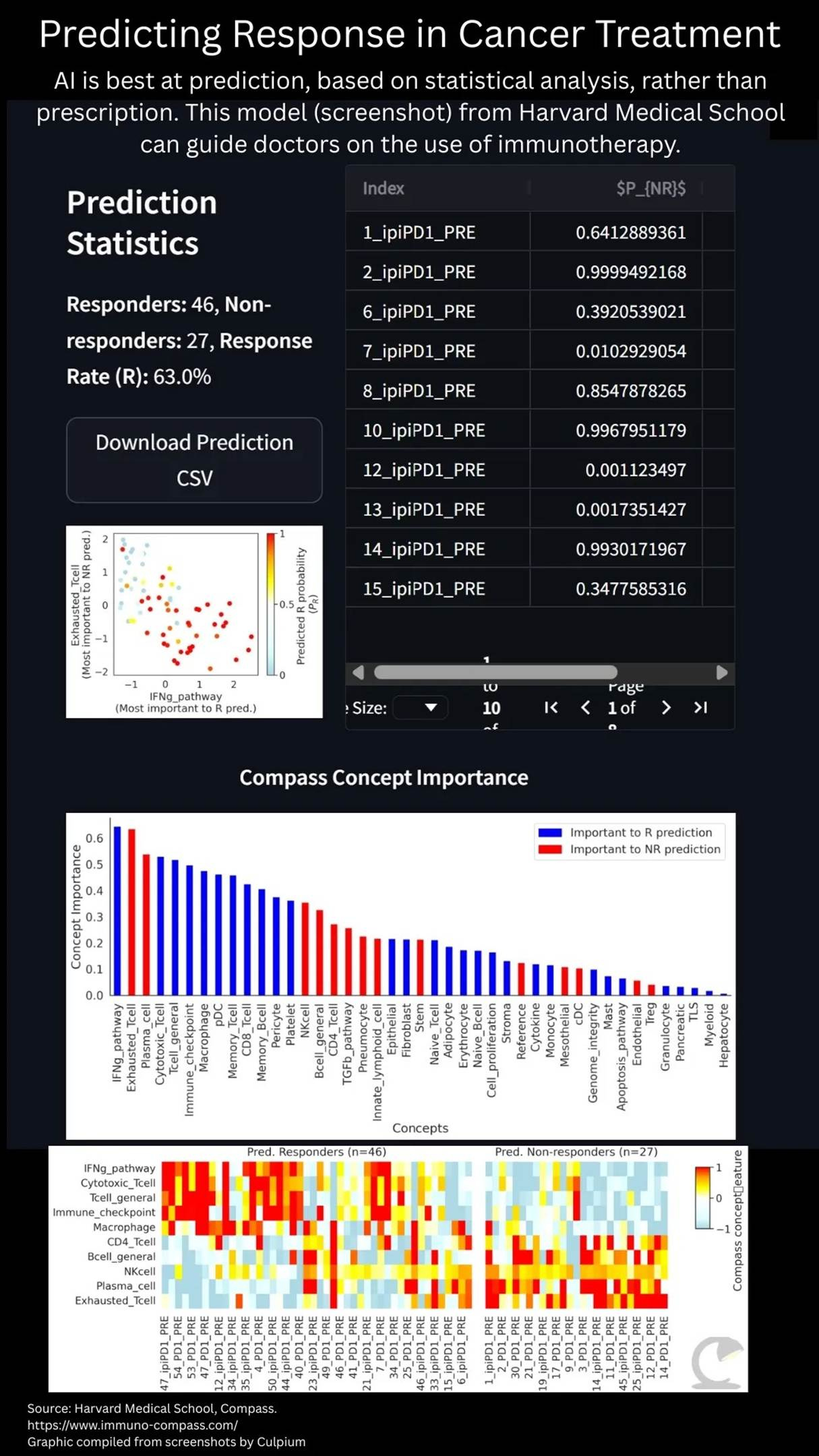

另一個更令人印象深刻的是哈佛醫學院研究人員所開發的 Compass model,這篇論文「Generalizable AI predicts immunotherapy outcomes across cancers and treatments.」概述了該模型。研究團隊將上千個關於腫瘤、免疫療法及其結果輸入資料庫,讓醫生甚至病患皆可上傳腫瘤RNA以預測對免疫療法產生反應的可能性。

除了常見打頭陣的化療以外,免疫療法和基因治療更仔細地針對腫瘤,但後兩者不見得適用於所有情況。目前只有少數類型對免疫療法有反應,例如有表現PD-L1蛋白質的腫瘤。然而由於免疫療法利用人體自身的免疫系統對抗癌症,這個做法可能帶來顯著的負面影響,而且療程非常昂貴。能夠預測哪些腫瘤可能產生反應至關重要,醫生和病患得已做出更適合的決定,也省荷包。

基因治療面臨類似的挑戰,尤其是在許多癌症類型中缺乏可作為藥物靶點的標的。隨著AI被用來折疊蛋白質,發現新藥物和測試功效,開發新療法的費用和時間有機會大幅降低。這也意味著更多藥物可供選擇,包括迄今未受到製藥公司關切的罕見癌症類型。

AI的進步,由更強大的運算能力來處理大量資料所推動。這能夠協助第一世界和第三世界的醫護人員及患者,如同網路縮小了數位落差,AI有潛力彌合醫療保健的落差。

然而, AI是無法取代實際提供醫療保健的人員。

人們最常用的AI介面LLM永遠不應被視為真人醫生的代理人,我們不應寄望AI提供個人醫療建議或療程,血液檢查、X光和磁核共振也是如此,AI是幫我們發現問題的工具,而不是解決問題的手段。

人類疾病

癌症,作為人類最陰險且最令人困惑的疾病之一,將成為我們如何既擁抱又防範人工智慧進步的試金石。

我歷經過AI能做到的,不能做到的,以及其淺在的陷阱。

舉例而言,AI可以告訴你很多癌症患者選擇放棄治療以換取加速抵達生命的終點。它無法解釋原因,但醫生可以,他們親眼見到,親耳聽聞,也用自己的心感受過。他們本能地能夠明白黑暗的終點比緩慢又令人疲憊的治療過程更誘人,而且對於某些病患而言,康復甚至是永遠無法企及的目標。病患不是為了避免疼痛,現今有許多合法鴉片類藥物能控制緩解不適,他們想要擺脫失去控制和缺乏自主權的感受,AI模型在這方面毫無幫助。

真要說此刻能做到什麼,LLM回覆的冰冷科學真相反而讓痛苦加劇。大部分病患將多年遭受治療副作用的影響,聊天機器人會告訴你「許多症狀會永遠與你同在」,但它不會告訴你的是這些症狀不僅不斷提醒你那瀕臨死亡的經歷,而且持續警告你細胞中有一顆不定時炸彈隨時再次滴答作響,沒有人願意活在這種陰霾之下,不論緩解帶來多多的生活樂趣。

只要按下鍵盤,就能獲得關於療程後副作用如此「有用的訊息」,即使最堅強的倖存者也有理由相信他們的生活頂峰已經過了,不會有好的未來。最聰明的生成型預訓練變換模型任然缺乏說服患者的EQ。

縱然時常有幻覺,GPT從設計層面來說是理性的,而人類則是感性的設計。我的醫生從來不曾對我說謊,就算是善意的謊言也不說。傳遞壞消息時也總是夾雜同理心和有助益的建議。對於患者來說,在這充滿不確定的時刻裡,眼神的交流或對話中的語氣是如此重要,這些微小的人性動作意味著全世界。

遇到挫折時,真人醫生能給予人性的建議。放療造成我有口乾的問題,放射腫瘤科醫生建議喝一大口橄欖油試試,這是AI從來沒有提到過的。

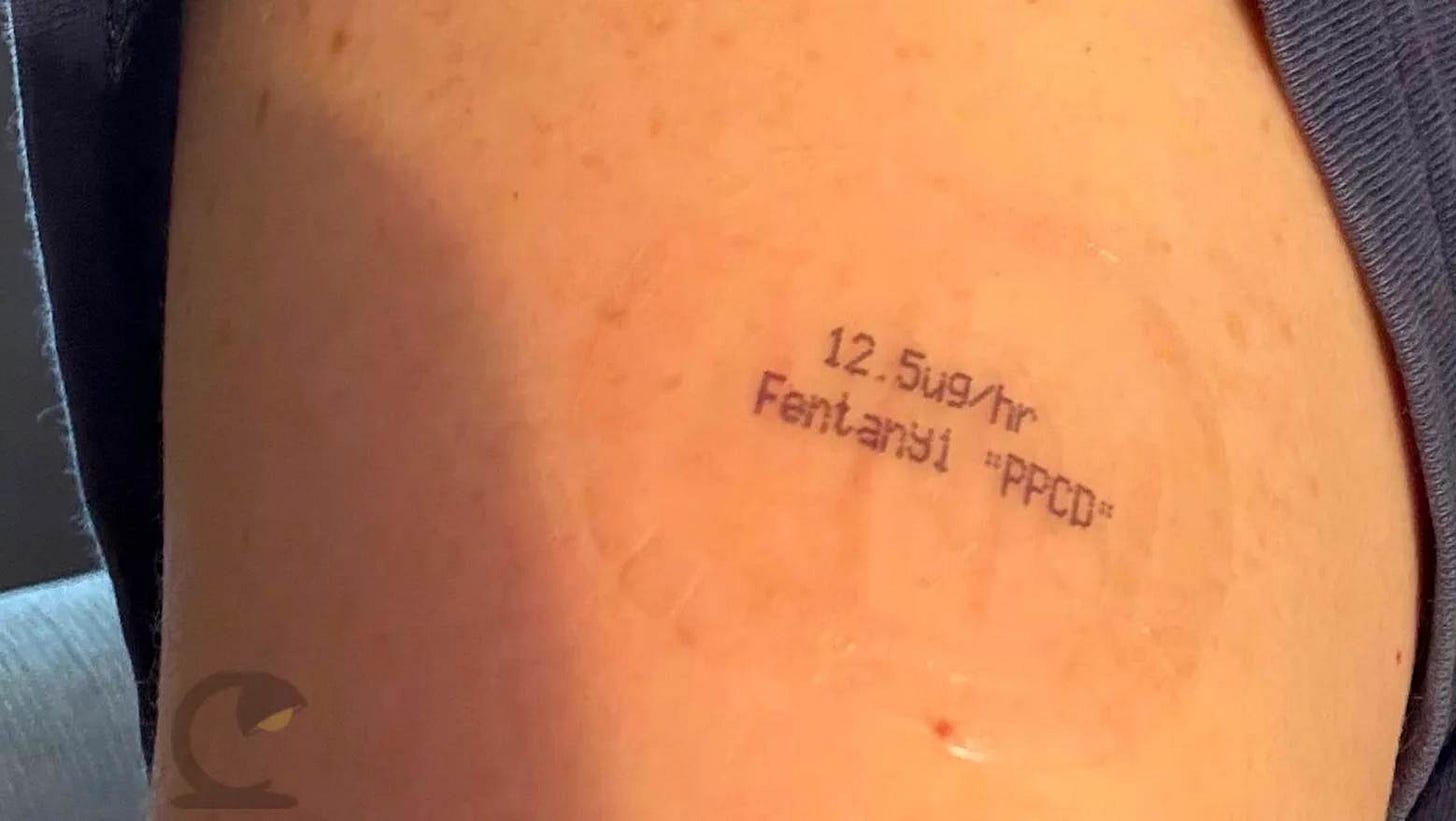

在我的治療和康復過程中,最艱辛的是對抗芬太尼上癮。從卡莫德開始,透過皮膚貼片給藥的芬太尼是我在鴉片類藥物所使用的最高劑量層。在療程的初期,我下定決心避免使用鴉片類藥物,那時的我,天真地以為布洛芬就夠了。然而,我屈服了。當同步放化療的影響消退,拔掉鼻胃管,臉上和脖子上的皮膚不再灼傷,我成了吸毒上癮者。疼痛已離我遠去,但是沒有芬太尼的日子使我坐立難安、直冒冷汗而且無法入眠。

當我帶著AI開立的戒毒處方籤去看腫瘤科醫生時,他指出這不比我已經上癮的藥物更好。每個AI聊天機器人都拍胸捕保證這個組合是對付鴉片類藥物成癮的標準療法。我的醫生開了一張更好更人性的處方:睡覺。由於當時我沒有在工作,可以藉由贊安諾讓我在睡眠中戒毒。這是我身為人類需要的解決方法,而且只有人類提得出來。

在黑暗的時刻,我無法進食、無法說話、幾乎無法呼吸,人類是我唯一的救贖。我本身是個科技通,學歷資工碩士,擔任科技記者二十餘載,電子產品和程式語言原本是我的舒適圈。現在,除非我的身體和心理感到不適,我不想再在網路上搜尋數據和答案,AI的虛情假意和機械式回覆讓我感到厭惡,他們是對是錯不再重要,我只能感受到他們的冰冷。我發現,追劇《無照律師》更能帶給我溫暖的慰藉,即便是虛構的人類抓馬,仍然勝過數位同情心。

我的病例合計有十多位醫生、二十多位護理師、眾多醫療技術人員、勤務人員、志工和行政人員經手。我列出了參與我療程的每一位,冷靜地分析哪部分可以被某種程度的AI、自動化設備或機器人取代,我的結論是不到五個,大部分是實驗室技術員或行政人員。

即使我有顆水晶球讓我能預見二十五年後人工智慧會帶我們走向何方,我確信AI無法取代任何一位伴我走過癌症疼痛、創傷和死亡幽谷的一線醫療人員。

但我也有些話想對那些熱情勤奮的醫生和護理師說:

請大膽放入您的人性,不要成為AI演算法下的犧牲品。人類不是統計數據,某種療法是百分之七十五或是百分之二十五有效並不重要。對於任何一位個別病患而言,這是死去或活下來的二元論。

就我的病例來說,療程開始初期我的勝算很高,但是當計劃失敗必須改用新的藥物治療時賠率進而對我不利,我心中的不確定感揮之不去。對於醫生來說每一位眼前的病患都可能是邊緣案例,統計數據裡的異常值,不論好壞。但是對於那位病患和其親友而言,每一位都是獨一無二,需要被視為N=1的病例。

我們所有人,不論是醫護人員、病患、技術人員或是政策制定者也需要牢記這最重要的事實:AI和醫療專業人員都可以提供資訊也都會犯錯。但是提供照護的,是人。

感謝您的閱讀。

中文翻譯:張咪咪,中文編輯:林筱茵

我計畫休息幾個月,情況不如前一次一般嚇人,但是我需要一些時間休息和復原。謝謝您過去一年的支持,祝您有個健康快樂的節日。

「全球疾病負擔研究」,和 The Lancet. Volume 406, Issue 10512 p1536-1537, 2025年10月11日,和 WHO。